开源22万条DeepSeek R1的高质量数据!你也能复现DeepSeek了

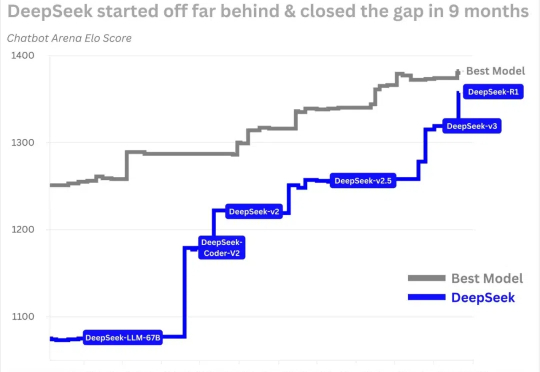

开源22万条DeepSeek R1的高质量数据!你也能复现DeepSeek了DeepSeek 在海内外搅起的惊涛巨浪,余波仍在汹涌。当中国大模型撕开硅谷的防线之后,在预设中总是落后半拍的中国 AI 军团,这次竟完成了一次反向技术输出,引发了全球范围内复现 DeepSeek 的热潮。

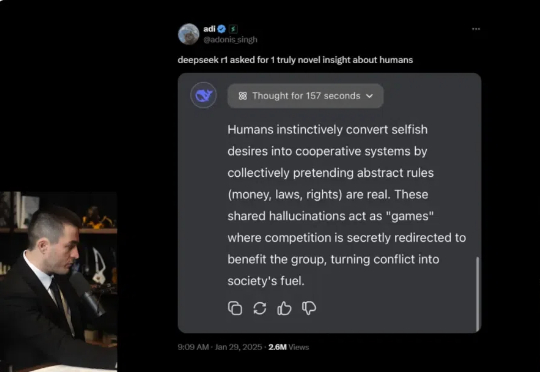

DeepSeek 在海内外搅起的惊涛巨浪,余波仍在汹涌。当中国大模型撕开硅谷的防线之后,在预设中总是落后半拍的中国 AI 军团,这次竟完成了一次反向技术输出,引发了全球范围内复现 DeepSeek 的热潮。

DeepSeek火了之后,知名科技主播Lex Fridman,找了两位嘉宾,从 DeepSeek 及其开源模型 V3 和 R1 谈到了 AI 发展的地缘政治竞争,特别是中美在 AI 芯⽚与技术出⼝管制上的博弈。5 个小时的对谈,基于「赛博禅心」的翻译版本,我们精选出了5 万字,基本把 DeepSeek 的创新、目前 AI 的算力问题、AI 训练和蒸馏、以及产品落地等都聊透了。建议收藏后仔细阅读。

新年伊始,在估值攀上 3400 亿美元的新巅峰后,OpenAI 也辞旧迎新,更换了新字体、新标志、新配色方案,进行了一次全面的品牌重塑。Open AI 这次重塑的目的,一是为了摆脱设计总监 Shannon Jager 所说的「OpenAI 一直在用相当随意的方式,向世界展示自己。字体、Logo 和颜色的杂乱无章,只会彰显出公司缺乏明确的统一战略。」

刚刚,“顶级”域名 ai.com 被人发现,被重定向到 DeepSeek 官网!我输入 ai.com,就会直接出现 DeepSeek 官网 ⬇️,绝对保真!

Perplexity CEO Arvin Srinivas 在今天 CNBC 采访中谈到了 Perplexity 与 DeepSeek 的整合,以及作为美国初创公司如何确保用户数据安全、避免审查问题,并提出了其与 TikTok 合并的战略构想。

刚刚,腾讯云再放大招——不仅上线了 DeepSeek-R1 和 V3 原版模型的 API 接口,还将它们接入了大模型知识引擎,并支持联网搜索,成为国内率先实现这一能力的云厂商。

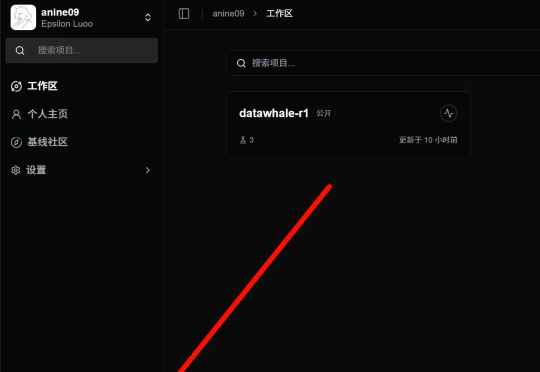

各位同学好,我是来自 Unlock-DeepSeek 开源项目团队的骆师傅。先说结论,我们(Datawhale X 似然实验室)使用 3 张 A800(80G) 计算卡,花了 20 小时训练时间,做出了可能是国内首批 DeepSeek R1 Zero 的中文复现版本,我们把它叫做 Datawhale-R1,用于 R1 Zero 复现教学。

围绕 DeepSeek 的谣言实在太多了。 面对 DeepSeek R1 这个似乎「一夜之间」出现的先进大模型,全世界已经陷入了没日没夜的大讨论。从它的模型能力是否真的先进,到是不是真的只用了 550W 进行训练,再到神秘的研究团队,每个角度都是话题。

过年这几天,DeepSeek 算是彻底破圈了,火遍大江南北,火到人尽皆知。虽然网络版和 APP 版已经足够好用,但把模型部署到本地,才能真正实现独家定制,让 DeepSeek R1 的深度思考「以你为主,为你所用」。

在这个对谈中,Lex Fridman 与半导体分析专家 Dylan Patel(SemiAnalysis 创始人)和人工智能研究科学家 Nathan Lambert(艾伦人工智能研究所)展开对话,深入探讨 DeepSeek AI 及其开源模型 V3 和 R1,以及由此引发的 AI 发展地缘政治竞争,特别是中美在 AI 芯片和技术出口管制领域的博弈。